Meningsmålinger – hvad er det de rammer?

Hvis I har været ovre på vores grafik-side og kigge, undrer I jer måske over, hvorfor der ikke er kommet en 2019-prognose op endnu. Sidste gang der var valg tog vi udgangspunkt i, at meningsmålingerne nok på en eller anden måde ville ramme. Det gjorde de ikke, sådan ikke spot on, i hver fald, så vi ramte heller ikke spot on.

Det gør vi bedre denne gang, ved at gå lidt mere grundigt til værks. Og det kræver at vi ser på, hvordan meningsmålinger har ramt valgresultater historisk. Første del af den fortælling kommer i dag, og den handler om systematisk og ikke-systematisk usikkerhed.

Valget 2007 – en historie om statistisk usikkerhed.

Selvom et meningsmålingsinstitut gør alt rigtigt, og får spurgt et fuldstændigt repræsentativt udsnit af befolkningen, og selvom alle dem de spørger, stemmer det samme som de har sagt i meningsmålingen, så er der stadig usikkerhed tilbage i en meningsmåling.

Den kommer fra, at man ikke spørger alle 3,5 mio. stemmeberettigede, men normalt kun spørger mellem 1000 og 2000. Hvis man forestiller sig at 20% vil stemme S, og man spørger 1000 mennesker hvad de vil stemme, så kan man ikke være sikker på at præcis 200 svarer S. Nogle gange vil det være 190, nogle gange vil det være 215. 95% af gangene vil det være mellem 176 og 225, så meningsmålingsinstituttet vil med 95% sandsynlighed måle mellem 17,6% og 22,5%.

I virkeligheden er det det omvendte problem man skal løse. Givet at 20% af de 1000 svarede S, hvad tror vi så sandsynligheden er blandt de 3,5 mio.? Så bruger man beregningen ovenfor, og siger at den rigtige sandsynlighed ligger mellem 17,6% og 22,5% med 95% konfidens. Eller sagt på en anden måde, så skal man ikke blive overrasket hvis valgresultatet afviger med 2,5% fra meningsmålingen.

Det er det, man normalt forstår med statistisk usikkerhed. Det er en form for usystematisk usikkerhed, fordi meningsmålingernes statistiske usikkerhed peger i tilfældige retninger.

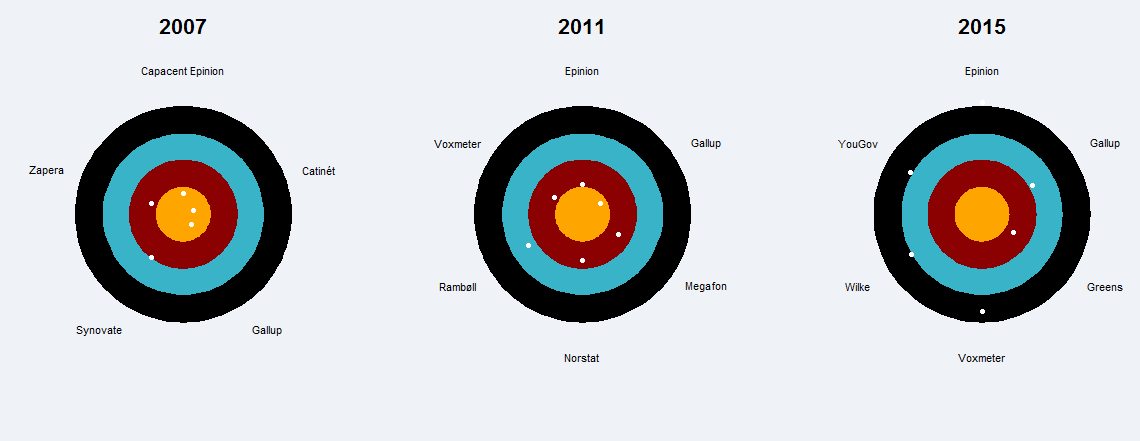

I 2007 lå meningsmålingerne dagen før valget sådan her:

| Parti | Capacent Epinion | Catinét | Gallup | Synovate | Zapera | Valgresultat |

|---|---|---|---|---|---|---|

| A | 25.9 | 25.8 | 25.4 | 26.3 | 27 | 25.5 |

| B | 5.8 | 5.4 | 5.1 | 5.7 | 4.7 | 5.1 |

| C | 11.1 | 10 | 9.4 | 12.1 | 11.9 | 10.4 |

| F | 12.6 | 13.9 | 13.1 | 13.3 | 12.5 | 13 |

| K | 1.2 | 1.2 | 1 | 0.7 | 0.9 | 0.9 |

| O | 13.2 | 13.7 | 14.1 | 10.7 | 12.3 | 13.9 |

| Ø | 2.6 | 2.1 | 1.8 | 2.2 | 1.6 | 2.2 |

| V | 24.8 | 25.3 | 27.8 | 26.4 | 25.5 | 26.2 |

Det vides ikke hvor mange der er blevet spurgt, men vi gætter på 1200 i hver meningsmåling.

Ramte de så valgresultatet? Hvis man bare ser på forskellene, ser det da ud som om at de fleste er inden for et par procent. Men skal man passe på: Hvis procenterne for ét parti afviger med 2,5% er det ikke overraskende. Omvendt ville det være overraskende hvis de alle sammen gør.

Hvor godt de rammer, kan man samle i et enkelt tal, χ2 (det er det græske bogstav chi). Det er en slags afstand (i anden potens) mellem meningsmåling og valgresultat, og man vil generelt forvente at den er samme størrelse som antallet af partier (minus 1). Hvis den er meget større, kan den statistiske usikkerhed ikke forklare forskellen.

Man kan faktisk gå længere og sige hvad sandsynligheden er, for at χ2 har den værdi den har eller større. Man siger normalt, at hvis der er mindre end 5% sandsynlighed for at få så høj en χ2-værdi, så må der være noget andet end statistisk usikkerhed på spil.

Og sådan ser det ud:

| Institut | Forventet χ2 | χ2 | p-værdi, % |

|---|---|---|---|

| Capacent Epinion | 7 | 5.3 | 61.8 |

| Catinét | 7 | 2.8 | 89.9 |

| Gallup | 7 | 3.4 | 84.8 |

| Synovate | 7 | 14 | 5.2 |

| Zapera | 7 | 8.7 | 27.8 |

Faktisk ser det ud til at de alle sammen rammer inden for skiven! De ligger alle sammen med en p-værdi over 5%, så de kan alle sammen påstå at de har ramt. Eller rettere, man kan ikke afvise at de kommer fra valgresultatets population.

Valget 2011 – en historie om systematisk usikkerhed

Nu kører det, så lad os rulle frem til 2011. Her har I det sidste sæt meningsmålinger før valget

| Parti | Epinion | Gallup | Megafon | Norstat | Rambøll | Voxmeter | Valgresultat |

|---|---|---|---|---|---|---|---|

| A | 25.4 | 25.1 | 25 | 25.8 | 25 | 26.1 | 24.8 |

| B | 9.6 | 9.2 | 9.7 | 9.1 | 9.4 | 9.9 | 9.5 |

| C | 5.8 | 5.5 | 6 | 6.1 | 6.2 | 5.8 | 4.9 |

| F | 10.5 | 10.7 | 10.6 | 11 | 10.7 | 9.9 | 9.2 |

| I | 5.2 | 4.9 | 5.2 | 4.4 | 5.3 | 4.9 | 5 |

| K | 0.7 | 0.8 | 0.8 | 0.8 | 0.9 | 0.5 | 0.8 |

| O | 12.1 | 12.1 | 12.8 | 11.8 | 11.5 | 10.7 | 12.3 |

| Ø | 6.2 | 6.2 | 5.8 | 6.1 | 7.6 | 6.6 | 6.7 |

| V | 24.4 | 25.4 | 24.1 | 24.9 | 23 | 25.4 | 26.7 |

Hvis man laver den samme analyse igen, får man

| Institut | Forventet χ2 | χ2 | p-værdi, % |

|---|---|---|---|

| Epinion | 8 | 8.7 | 36.5 |

| Gallup | 8 | 6.1 | 63.3 |

| Megafon | 8 | 12.1 | 14.5 |

| Norstat | 8 | 13.6 | 9.4 |

| Rambøll | 8 | 18.4 | 1.8 |

| Voxmeter | 8 | 9.7 | 28.7 |

Det ser ikke helt lige så pænt ud, men alle institutter (på nær Rambøll) kan stadig sige, at de har ramt inden for deres forventede usikkerhed.

Nu kunne man jo få den idé at man kunne reducere usikkerheden i meningsmålinger ved at lægge dem sammen. Det er der også mange der gør. Så lad os gøre det, og se hvad der sker. Man kan lave den samme analyse som vi har gjort for hvert institut ovenfor. Så får vi

| År | Forventet χ2 | χ2 | p-værdi, % |

|---|---|---|---|

| 2007 | 7 | 9.5 | 21.9 |

| 2011 | 8 | 53 | 0 |

Hvad skete der lige her? I 2007 lå gennemsnitsmålingen tæt på valgresultatet, men det gjorden den ikke i 2011. Når man kigger nærmere på tallene, kan man se, at alle målingerne i 2011 var skæve i den samme retning, i modsætning til 2007 hvor de var skæve i forskellige retninger.

I 2011 er der altså systematisk usikkerhed i meningsmålingerne som man ikke så i 2007. Man laver ikke en bedre meningsmåling ved at tage gennemsnittet, når alle meningsmålingerne hælder den samme vej. Og hvorvidt de hælder den samme vej, ved man ikke før valget er gjort op.

Valget 2015 – bare en masse usikkerhed

Før der er nogen der spørger, skal vi også lige runde valget i 2015. Hvis man ser på de individuelle meningsmålinger og på gennemsnittet (vægtet med antal respondenter) får man nedslående resultater hele vejen rundt.

Hvis I virkelig insisterer på at se målingerne har I dem her. I husker måske at det gik overraskende godt for Dansk Folkeparti og overraskende dårligt for SF

| Parti | Epinion | Gallup | Greens | Voxmeter | Wilke | YouGov | Valgresultat |

|---|---|---|---|---|---|---|---|

| A | 24.1 | 25.4 | 24.6 | 26.6 | 25.9 | 24.5 | 26.3 |

| Å | 4.2 | 4.7 | 5 | 3.9 | 5 | 5.1 | 4.8 |

| B | 5 | 5.1 | 4.7 | 5 | 5.6 | 6.3 | 4.6 |

| C | 4.3 | 3.7 | 3.3 | 3 | 4.6 | 4.2 | 3.4 |

| F | 6.2 | 4.9 | 5.6 | 6.4 | 5.7 | 5.7 | 4.2 |

| I | 7.5 | 7.2 | 7.7 | 8.1 | 8.3 | 7.7 | 7.5 |

| K | 0.9 | 1.1 | 0.7 | 0.8 | 1.3 | 0.9 | 0.8 |

| O | 18.4 | 18 | 19.2 | 15.7 | 16.7 | 19 | 21.1 |

| Ø | 9 | 8.6 | 9.4 | 8.4 | 8.1 | 8.3 | 7.8 |

| V | 20.3 | 21.2 | 19.8 | 21.9 | 18.8 | 18.2 | 19.5 |

Man kan også se på, om det kan afvises at de enkelte målinger har ramt inden for deres statistiske usikkerhed. Én af dem har ikke ramt helt voldsomt skævt, men ellers ser det ret skidt ud

| Institut | Forventet χ2 | χ2 | p-værdi, % |

|---|---|---|---|

| Epinion | 9 | 37.2 | 0.0 |

| Gallup | 9 | 19.4 | 2.2 |

| Greens | 9 | 12.3 | 19.9 |

| Voxmeter | 9 | 32.6 | 0.0 |

| Wilke | 9 | 27.0 | 0.1 |

| YouGov | 9 | 27.5 | 0.1 |

Konklusion

En vigtig lære af de seneste tre valgs meningsmålinger er, at den statistiske usikkerhed godt kan bidrage til usikkerhed om valgets resultat. Der behøver ikke at være mere usikkerhed end den statistiske, men det kan der sagtens.

Når man prøver at aggregere meningsmålinger bliver det altså ikke nødvendigvis bedre bare at lægge svarene sammen. Meningsmålingerne kan skyde forkert af alle mulige årsager, og de systematiske fejl de laver kommer man aldrig af med.

Følg med her på siden eller på Facebook (@hvisdervarvalgimorgen) eller Twitter (@HvisDerVarValg). Næste gang graver vi os lidt dybere ned i usikkerhederne i meningsmålinger. Det bli’r spas!